La Búsqueda de Google se está volviendo más inteligente al implementar el modelo unificado multitarea (MUM) patentado. En el evento Search On del miércoles, la compañía con sede en Mountain View, California, anunció una serie de actualizaciones en la Búsqueda de Google que aprovecharán MUM para mejorar la experiencia del usuario. Google también está trayendo una página de búsqueda rediseñada para los usuarios donde utilizará inteligencia artificial y MUM para ofrecer resultados más profundos sobre varios temas. Los usuarios también obtendrán una nueva experiencia al buscar videos en el motor de búsqueda. Traerá videos relacionados a un video en particular. Además, Google anunció Address Maker que utiliza códigos Plus de código abierto para proporcionar direcciones funcionales a escala. La aplicación de Google en iOS también se actualiza con la integración de Google Lens. Google también está actualizando Chrome con el soporte de Google Lens.

Uno de los mayores cambios que MUM está trayendo a la Búsqueda de Google es la capacidad de encontrar resultados con imágenes y texto simultáneamente. En el evento Search On, Google mostró que MUM está permitiendo que Google Lens permita a los usuarios buscar imágenes agregando sus consultas en texto. Entonces, por ejemplo, podrá encontrar resultados sobre cómo puede reparar su bicicleta capturando una imagen de su parte rota usando Google Lens.

Google está usando MUM para permitir que los usuarios busquen imágenes agregando sus consultas en texto

Crédito de la foto: Google

Del mismo modo, puede buscar algo que sea difícil de describir con precisión con palabras tomando sus fotografías a través de Google Lens. Solo necesitará tocar el ícono de Lente para buscar los resultados en tales casos.

Google demostró esta actualización tomando una foto de una camisa y pidiendo al motor de búsqueda que encontrara el mismo patrón pero en calcetines.

“Al combinar imágenes y texto en una sola consulta, estamos facilitando la búsqueda visual y la expresión de sus preguntas de una manera más natural”, dijo la compañía.

Estas nuevas capacidades de búsqueda se están experimentando actualmente, aunque Google dijo que los usuarios podrían experimentarlas en los próximos meses.

Google demostró cómo funcionaría la búsqueda mejorada mediante consultas visuales y de texto

Crédito de la foto: Google

Google también anunció la página de búsqueda rediseñada que utilizará los avances de AI y MUM para proporcionar resultados más naturales. El rediseño traerá una sección llamada Cosas que saber para dar resultados más profundos sobre nuevos temas. La nueva sección mostrará enlaces al contenido que no vería en los resultados de búsqueda habituales.

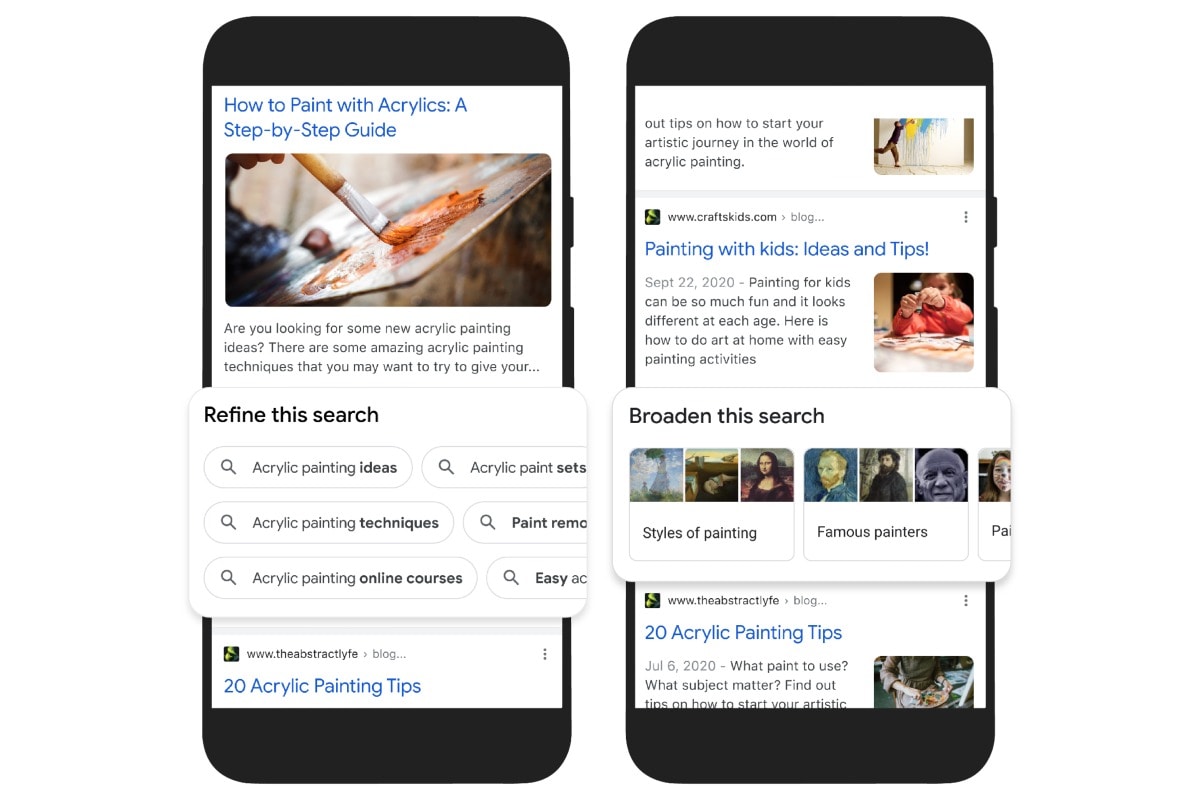

La página de búsqueda de Google rediseñada también incluirá funciones para permitir a los usuarios refinar y ampliar sus búsquedas. Por ejemplo, si un usuario está buscando pintura acrílica, las funciones para refinar las búsquedas mostrarán técnicas específicas como el vertido en charcos o el arte clásico que puede tomar para aprender sobre la nueva habilidad. Del mismo modo, la opción de ampliar búsquedas le permitirá ampliar su consulta de búsqueda con temas relacionados, como otros métodos de pintura y pintores famosos.

Google no proporcionó una línea de tiempo sobre el lanzamiento de estas funciones, aunque mencionó que los usuarios comenzarán a obtenerlas en los próximos meses. MUM se anunció por primera vez en Google I / O a principios de este año.

Los usuarios de la Búsqueda de Google también podrán ver páginas visualmente ricas donde los artículos, imágenes y videos estarán disponibles en una sola página. Esta nueva página ya está disponible y puede probarla buscando “Ideas de decoración de Halloween” o “Ideas de jardín vertical interior”.

Google también está avanzando en las búsquedas de videos en su sitio al traer una sección de videos relacionados. La compañía dijo que la nueva experiencia identificará temas relacionados en un video, con enlaces para permitir a los usuarios profundizar más fácilmente en una consulta específica para saber más sobre ella, sin pasar múltiples consultas de búsqueda.

Además de simplemente tomar pistas del título y los metadatos de los resultados del video, Google dijo que usará MUM para mostrar temas relacionados en los resultados del video, incluso si no se mencionan explícitamente en el primer video. Esto comenzará a implementarse en las próximas semanas en inglés, y los usuarios recibirán más mejoras visuales en los próximos meses.

La existencia Acerca de este resultado en la Búsqueda de Google también está recibiendo una actualización con conocimientos como la información sobre la fuente, lo que otros han dicho y más sobre el tema. Estos cambios estarán disponibles en las próximas semanas en inglés en los EE. UU.

Google también está actualizando su aplicación nativa para usuarios de iOS con un modo Lens, similar a cómo ha proporcionado la integración Lens en su aplicación Android. Esto le permitirá buscar imágenes y elementos visuales que se puedan comprar. Inicialmente, la integración de Google Lens se limitará a los usuarios de EE. UU.

Además de la aplicación de Google para iOS, Google también está llevando su integración de Lens al navegador Chrome en el escritorio. Le permitirá seleccionar imágenes, videos y contenido de texto en un sitio web para obtener rápidamente su información adicional en la misma pestaña, sin salir de la página que está navegando. Esta actualización estará disponible para usuarios de todo el mundo en los próximos meses.

Además, Google está brindando una experiencia de búsqueda más fácil de comprar al permitir que los usuarios vean un feed visual de productos como ropa y artículos de decoración del hogar junto con información como tiendas locales, guías de estilo y videos. Actualmente está limitado a los EE. UU. Y funciona con el Gráfico de compras de Google, que se dice que es un conjunto de datos en tiempo real de productos, inventario y comerciantes con más de 24 mil millones de listados.

Google facilita a los usuarios la compra de nuevos productos mediante su búsqueda mejorada

Crédito de la foto: Google

Para sus usuarios en EE. UU. Y mercados selectos, incluidos Australia, Austria, Brasil, Canadá, Dinamarca, Francia, Alemania, Japón, Países Bajos, Nueva Zelanda, Noruega, Suecia y Suiza, Google también ofrece un filtro ‘en stock’ que ayudar a encontrar tiendas cercanas para artículos específicos.

Junto con las actualizaciones de la Búsqueda de Google, Google Maps está obteniendo la capa Wildfire para informar a los usuarios sobre la información de los incendios forestales. Se basa en datos satelitales e incluirá sitios web de emergencia, números de teléfono e información de evacuación de los gobiernos locales para ayudar a los usuarios. La capa Wildfire estará disponible para los usuarios de Google Maps en todo el mundo en Android, iOS y computadoras de escritorio a partir de octubre.

Google también llevará Tree Canopy Insights a más de 100 ciudades de todo el mundo, incluidas Guadalajara, Londres, Sydney y Toronto durante la primera mitad de 2022. La herramienta Tree Canopy se experimentó por primera vez en Los Ángeles el año pasado. Utiliza imágenes aéreas y capacidades de inteligencia artificial para identificar los lugares que tienen mayor riesgo de experimentar un rápido aumento de las temperaturas. La herramienta ayudará a los gobiernos locales a tener acceso gratuito a información sobre dónde plantar árboles para aumentar la sombra y reducir el calor con el tiempo, dijo la compañía.

Además, Google está utilizando Plus Codes para ayudar a proporcionar direcciones a las personas que utilizan su nueva herramienta llamada Address Maker. La compañía dijo que la herramienta ayudó a que las comunidades no fueran atendidas en cuestión de semanas.

El creador de direcciones de Google se basa en códigos Plus para ayudar a asignar direcciones a las masas

Crédito de la foto: Google

Google ha creado una aplicación Address Maker para gobiernos locales y ONG para ayudarlos a crear direcciones utilizando Plus Codes. La aplicación está disponible para su descarga a través de Google Play para organizaciones aprobadas y les permite crear áreas de trabajo para ser abordadas; asignar nuevas áreas de trabajo; agregue caminos, calles, callejones y caminos; y generar y validar direcciones de código Plus para propiedades.

Originalmente, Google desarrolló Address Maker para llevar direcciones a comunidades desatendidas en Kolkata, India. Sin embargo, también ha sido utilizado por gobiernos y ONG en Gambia, Sudáfrica, Kenia y Estados Unidos, dijo la compañía.