Jakub Porzycki | Nurfoto | Imágenes falsas

OpenAI y Anthropic, las dos nuevas empresas de inteligencia artificial mejor valoradas, acordaron permitir que el Instituto de Seguridad de IA de EE. UU. pruebe sus nuevos modelos antes de lanzarlos al público, tras las crecientes preocupaciones en la industria sobre la seguridad y la ética en la IA.

El instituto, ubicado dentro del Departamento de Comercio del Instituto Nacional de Estándares y Tecnología (NIST), dijo en un comunicado de prensa que tendrá “acceso a los principales modelos nuevos de cada empresa antes y después de su lanzamiento público”.

El grupo se estableció después de que la administración Biden-Harris emitiera la primera orden ejecutiva del gobierno de EE. UU. sobre inteligencia artificial en octubre de 2023, que requería nuevas evaluaciones de seguridad, orientación sobre equidad y derechos civiles e investigación sobre el impacto de la IA en el mercado laboral.

“Estamos felices de haber llegado a un acuerdo con el Instituto de Seguridad de IA de EE. UU. para las pruebas previas al lanzamiento de nuestros modelos futuros”, escribió el director ejecutivo de OpenAI, Sam Altman, en una publicación en X. OpenAI también confirmó a CNBC el jueves que, en el último año , la empresa ha duplicado su número de usuarios activos semanales a 200 millones. Axios fue el primero en informar sobre el número.

La noticia llega un día después de que surgieran informes de que OpenAI está en conversaciones para recaudar una ronda de financiación que valora a la empresa en más de 100 mil millones de dólares. Thrive Capital lidera la ronda e invertirá mil millones de dólares, según una fuente con conocimiento del asunto que pidió no ser identificada porque los detalles son confidenciales.

Anthropic, fundada por ex ejecutivos y empleados de investigación de OpenAI, fue valorada más recientemente en 18.400 millones de dólares. recuentos antrópicos Amazonas como inversor líder, mientras que OpenAI cuenta con un fuerte respaldo de microsoft.

Los acuerdos entre el gobierno, OpenAI y Anthropic “permitirán la investigación colaborativa sobre cómo evaluar las capacidades y los riesgos de seguridad, así como los métodos para mitigar esos riesgos”, según el comunicado del jueves.

Jason Kwon, director de estrategia de OpenAI, dijo a CNBC en un comunicado que “apoyamos firmemente la misión del Instituto de Seguridad de IA de EE. UU. y esperamos trabajar juntos para informar las mejores prácticas y estándares de seguridad para los modelos de IA”.

Jack Clark, cofundador de Anthropic, dijo que la “colaboración de la compañía con el Instituto de Seguridad de IA de EE. UU. aprovecha su amplia experiencia para probar rigurosamente nuestros modelos antes de su implementación generalizada” y “fortalece nuestra capacidad para identificar y mitigar riesgos, promoviendo el desarrollo responsable de la IA”.

Varios desarrolladores e investigadores de IA han expresado su preocupación por la seguridad y la ética en la industria de la IA, cada vez más lucrativa. Los empleados actuales y anteriores de OpenAI publicaron una carta abierta el 4 de junio, describiendo problemas potenciales con los rápidos avances que se están produciendo en la IA y la falta de supervisión y protección de los denunciantes.

“Las empresas de IA tienen fuertes incentivos financieros para evitar una supervisión efectiva, y no creemos que las estructuras personalizadas de gobierno corporativo sean suficientes para cambiar esto”, escribieron. Las empresas de IA, añadieron, “actualmente sólo tienen obligaciones débiles de compartir parte de esta información con los gobiernos, y ninguna con la sociedad civil”, y no se puede “confiar en que la compartan voluntariamente”.

Días después de la publicación de la carta, una fuente familiarizada con el asunto confirmó a CNBC que la FTC y el Departamento de Justicia estaban listos para abrir investigaciones antimonopolio sobre OpenAI, Microsoft y Nvidia. La presidenta de la FTC, Lina Khan, describió la acción de su agencia como una “investigación de mercado sobre las inversiones y asociaciones que se están formando entre los desarrolladores de IA y los principales proveedores de servicios en la nube”.

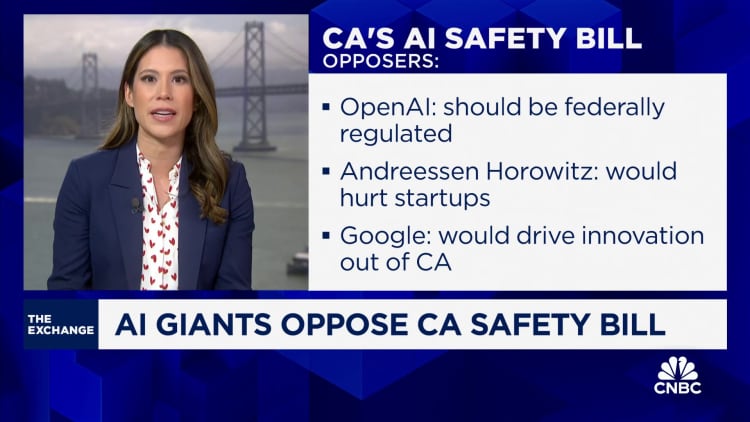

El miércoles, los legisladores de California aprobaron un proyecto de ley de seguridad de la IA candente y lo enviaron al escritorio del gobernador Gavin Newsom. Newsom, un demócrata, decidirá vetar la legislación o convertirla en ley antes del 30 de septiembre. El proyecto de ley, que haría obligatorias las pruebas de seguridad y otras salvaguardias para los modelos de IA de cierto costo o potencia informática, ha sido impugnado por algunos empresas de tecnología por su potencial para frenar la innovación.

MIRAR: Google, OpenAI y otros se oponen al proyecto de ley de seguridad de la IA de California