El director ejecutivo de Google, Sundar Pichai (izq.), y el director ejecutivo de Apple, Tim Cook (der.), escuchan mientras el presidente estadounidense, Joe Biden, habla durante una mesa redonda con líderes empresariales estadounidenses e indios en el Salón Este de la Casa Blanca en Washington, DC, el 23 de junio de 2023.

Anna hace dinero | imágenes falsas

Manzana dijo el lunes que los modelos de inteligencia artificial que sustentan Apple Intelligence, su sistema de inteligencia artificial, fueron entrenados previamente en procesadores diseñados por Google, una señal de que las grandes empresas de tecnología están buscando alternativas a NVIDIA cuando se trata del entrenamiento de IA de vanguardia.

La elección de Apple de de google La Unidad de Procesamiento Tensorial (TPU) de cosecha propia para capacitación se detalla en un documento técnico que acaba de publicar la empresa. Por otra parte, Apple lanzó el lunes una versión preliminar de Apple Intelligence para algunos dispositivos.

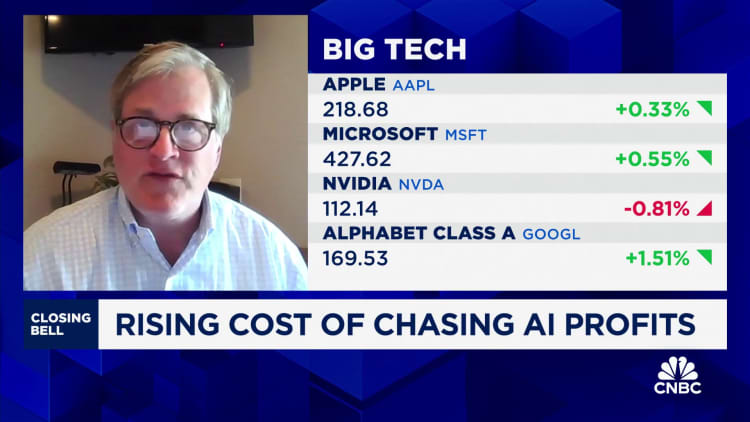

Las costosas unidades de procesamiento de gráficos (GPU) de Nvidia dominan el mercado de chips de entrenamiento de IA de alta gama y han tenido una demanda tan alta en los últimos dos años que ha sido difícil adquirirlas en las cantidades necesarias. abierta AI, microsofty Anthropic están utilizando las GPU de Nvidia para sus modelos, mientras que otras empresas de tecnología, incluida Google, Meta, Oráculo y tesla los están adquiriendo para desarrollar sus sistemas y ofertas de inteligencia artificial.

El director ejecutivo de Meta, Mark Zuckerberg, y el director ejecutivo de Alphabet, Sundar Pichai, hicieron comentarios la semana pasada sugiriendo que sus empresas y otras en la industria podrían estar invirtiendo demasiado en infraestructura de inteligencia artificial, pero reconocieron que el riesgo comercial de hacer lo contrario era demasiado alto.

“La desventaja de estar atrasado es que estás fuera de posición para la tecnología más importante durante los próximos 10 a 15 años”, dijo Zuckerberg en un podcast con Emily Chang de Bloomberg.

Apple no nombra a Google ni a Nvidia en su documento de 47 páginas, pero dice que su Apple Foundation Model (AFM) y su servidor AFM están entrenados en “clústeres de Cloud TPU”. Eso significa que Apple alquiló servidores de un proveedor de nube para realizar los cálculos.

“Este sistema nos permite entrenar los modelos AFM de manera eficiente y escalable, incluidos AFM en el dispositivo, AFM en el servidor y modelos más grandes”, dijo Apple en el documento.

Los representantes de Apple y Google no respondieron a las solicitudes de comentarios.

Apple reveló sus planes de IA más tarde que muchos de sus pares, que adoptaron en voz alta la IA generativa poco después del lanzamiento de ChatGPT por parte de OpenAI a fines de 2022. El lunes, Apple presentó Apple Intelligence. El sistema incluye varias características nuevas, como una apariencia renovada para Siri, un mejor procesamiento del lenguaje natural y resúmenes generados por IA en campos de texto.

Durante el próximo año, Apple planea implementar funciones basadas en IA generativa, incluida la generación de imágenes, la generación de emojis y un Siri potenciado que puede usar la información personal del usuario y realizar acciones dentro de las aplicaciones.

En el periódico del lunes, Apple dijo que el AFM en el dispositivo fue entrenado en una sola “porción” de chips 2048 TPU v5p trabajando juntos. Se trata del TPU más avanzado, lanzado por primera vez en diciembre. El servidor AFM fue entrenado en 8192 chips TPU v4 que fueron configurados para funcionar juntos como ocho segmentos a través de una red de centro de datos, según el documento.

Los últimos TPU de Google cuestan menos de 2 dólares por hora de uso del chip cuando se reservan con tres años de antelación, según el sitio web de Google. Google presentó por primera vez sus TPU en 2015 para cargas de trabajo internas y los puso a disposición del público en 2017. Ahora se encuentran entre los chips personalizados más maduros diseñados para inteligencia artificial.

Aún así, Google es uno de los principales clientes de Nvidia. Google utiliza las GPU de Nvidia y sus propias TPU para entrenar sistemas de inteligencia artificial y también vende acceso a la tecnología de Nvidia en su nube.

Apple dijo anteriormente que la inferencia, que significa tomar un modelo de IA previamente entrenado y ejecutarlo para generar contenido o hacer predicciones, ocurriría parcialmente en los propios chips de Apple en sus centros de datos.

Este es el segundo documento técnico sobre el sistema de inteligencia artificial de Apple, después de que en junio se publicara una versión más general. Apple dijo en ese momento que estaba utilizando TPU mientras desarrollaba sus modelos de IA.

Está previsto que Apple informe los resultados trimestrales después del cierre de operaciones del jueves.

MIRAR: Cómo el consumo masivo de energía de la IA generativa está sobrecargando nuestra red