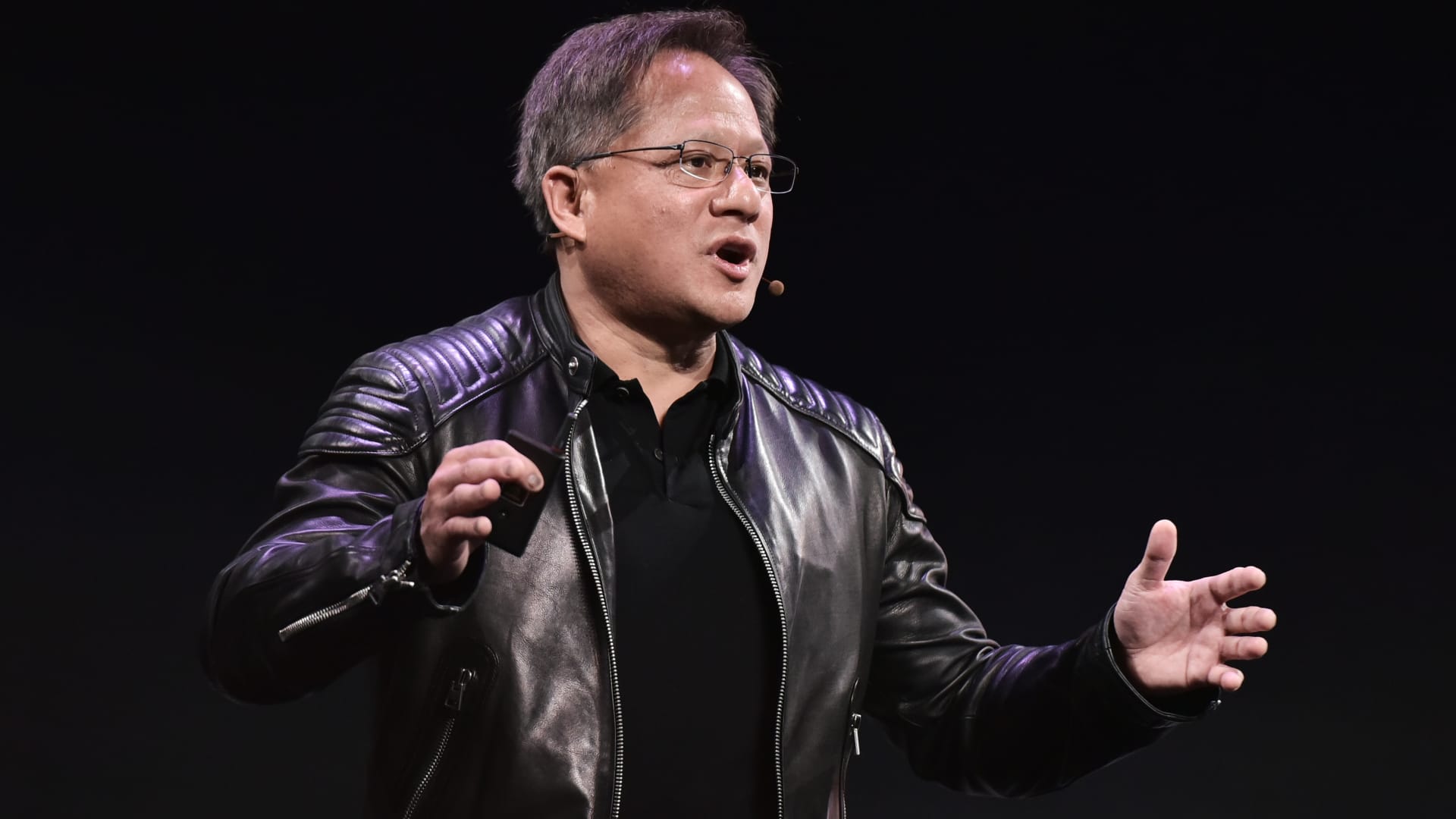

El CEO de Nvidia, Jensen Huang, con su chaqueta de cuero habitual.

Getty

nvidia anunció el martes un nuevo software que ayudará a los fabricantes de software a evitar que los modelos de IA indiquen datos incorrectos, hablen sobre temas dañinos o abran brechas de seguridad.

El software, llamado NeMo Guardrails, es un ejemplo de cómo la industria de la inteligencia artificial se esfuerza por abordar el problema de las “alucinaciones” con la última generación de modelos de lenguaje grande, que es un punto de bloqueo importante para las empresas.

Modelos de idiomas grandes, como GPT de microsoftOpenAI y LaMDA respaldados por Google, están entrenados en terabytes de datos para crear programas que pueden escupir bloques de texto que se leen como si los hubiera escrito un humano. Pero también tienen una tendencia a inventar cosas, lo que a menudo los practicantes llaman “alucinación”. Las primeras aplicaciones de la tecnología, como resumir documentos o responder preguntas básicas, necesitan minimizar las alucinaciones para ser útiles.

El nuevo software de Nvidia puede hacer esto agregando medidas de seguridad para evitar que el software aborde temas que no debería. NeMo Guardrails puede obligar a un chatbot LLM a hablar sobre un tema específico, evitar contenido tóxico y puede evitar que los sistemas LLM ejecuten comandos dañinos en una computadora.

“Puedes escribir un guión que diga, si alguien habla sobre este tema, no importa qué, responde de esta manera”, dijo Jonathan Cohen, vicepresidente de investigación aplicada de Nvidia. “No tiene que confiar en que un modelo de lenguaje seguirá un aviso o seguirá sus instrucciones. En realidad, lo que sucederá está codificado en la lógica de ejecución del sistema de barandas”.

El anuncio también destaca la estrategia de Nvidia para mantener su liderazgo en el mercado de chips de IA mediante el desarrollo simultáneo de software crítico para el aprendizaje automático.

Nvidia proporciona miles de procesadores gráficos necesarios para entrenar e implementar software como ChatGPT. Nvidia tiene más del 95% del mercado de chips de IA, según los analistas, pero la competencia está aumentando.

Cómo funciona

NeMo Guardrails es una capa de software que se encuentra entre el usuario y el modelo de lenguaje grande u otras herramientas de IA. Evita los malos resultados o las malas indicaciones antes de que el modelo las escupa.

Nvidia propuso un chatbot de servicio al cliente como un posible caso de uso. Los desarrolladores podrían usar el software de Nvidia para evitar que hable sobre temas fuera del tema o que se “salte del camino”, lo que plantea la posibilidad de una respuesta sin sentido o incluso tóxica.

“Si tiene un chatbot de servicio al cliente, diseñado para hablar sobre sus productos, probablemente no quiera que responda preguntas sobre nuestros competidores”, dijo Cohen de Nvidia. “Quieres monitorear la conversación. Y si eso sucede, diriges la conversación hacia los temas que prefieres”.

Nvidia ofreció otro ejemplo de un chatbot que respondió preguntas internas de recursos humanos corporativos. En este ejemplo, Nvidia pudo agregar “barandillas” para que el bot basado en ChatGPT no respondiera preguntas sobre el desempeño financiero de la empresa del ejemplo ni accediera a datos privados sobre otros empleados.

El software también puede usar un LLM para detectar alucinaciones al pedirle a otro LLM que verifique la respuesta del primer LLM. Luego devuelve “No sé” si el modelo no ofrece respuestas coincidentes.

Nvidia también dijo el lunes que el software de barandillas ayuda con la seguridad y puede obligar a los modelos LLM a interactuar solo con software de terceros en una lista permitida.

NeMo Guardrails es de código abierto y se ofrece a través de los servicios de Nvidia y se puede utilizar en aplicaciones comerciales. Los programadores utilizarán el lenguaje de programación Colang para escribir reglas personalizadas para el modelo de IA, dijo Nvidia.

Otras empresas de IA, incluidas Google y OpenAI, han utilizado un método llamado aprendizaje reforzado a partir de comentarios humanos para evitar resultados dañinos de las aplicaciones LLM. Este método utiliza evaluadores humanos que crean datos sobre qué respuestas son aceptables o no, y luego entrena el modelo de IA utilizando esos datos.

Nvidia está prestando cada vez más atención a la IA, ya que actualmente domina los chips utilizados para crear la tecnología. Montando la ola de IA que lo ha convertido en el mayor ganador en el S&P 500 en lo que va de 2023, con un aumento del 85% en las acciones a partir del lunes.

Corrección: los programadores usarán el lenguaje de programación Colang para escribir reglas personalizadas para el modelo de IA, dijo Nvidia. Una versión anterior tergiversó el nombre del idioma.